Elektronart synthesizes electronics and art

to serve you

consummate products

Best Price

You get more value for less budget

Receive on time

Stick to project schedule

Fast work turnaround

2nd prototype would be your final product

Reference Designs

Struggling with your new design, want to update existing one, need a brand new hardware or need firmware for your hardware.

If you need assistance for any of these you are in right place to start.

If you are thinking of hiring an outsourse designer, check my commercial references. They will guide you for your decision.

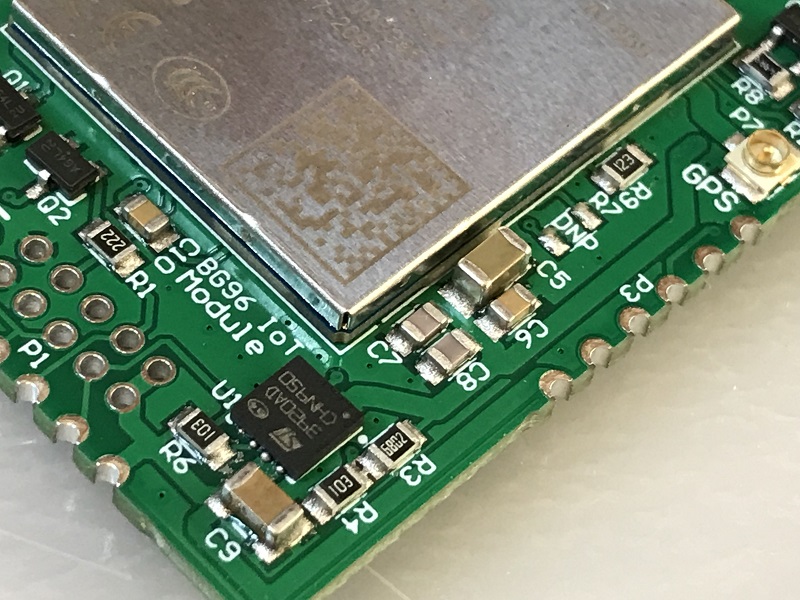

Public Sharing

Designing your own project and looking for working example, tested design and solution for your problem. I hope you get one here.

Check public designs to get inspired. Please note that non-public design are here as commercial references. Please do not ask for more information related to them.